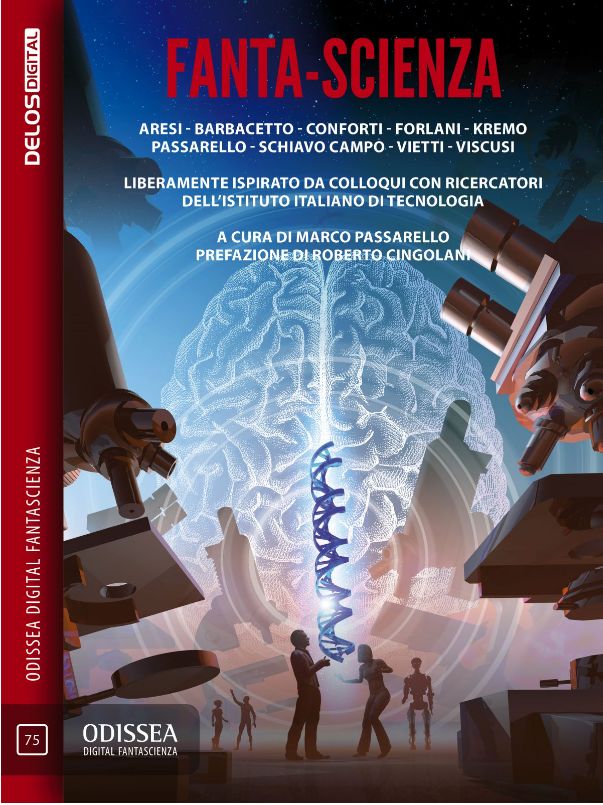

Dopo aver parlato qui per anni di libri altrui, è la volta che finalmente vi parlo di un libro mio: da qualche giorno è in vendita Fanta-Scienza, un’antologia di racconti che ho curato personalmente e che contiene anche un mio racconto. Un libro la cui lavorazione è stata parecchio travagliata, e di cui ho deciso di svelare qui tutte le complicate vicissitudini.

L’idea mi venne diversi anni fa, quando Repubblica Sera mi commissionò un articolo prendendo come spunto l’antologia Hieroglyph curata da Neal Stephenson, che si proponeva di diffondere una fantascienza più ottimista e a questo scopo aveva fatto scrivere dei racconti ispirati dalle previsioni per il futuro espresse dai ricercatori dell’università dell’Arizona. Una delle persone cui chiesi un commento fu Bruce Sterling, che mi scrisse:

I hope that more schools will see the good sense of this effort and try it themselves. If an Italian university tried it I would be the first to celebrate”.

L’approccio positivista di Stehpenson non mi convinceva affatto, ma l’idea di far collaborare ricercatori e scrittori per ottenere racconti di fantascienza mi sembrò molto interessante. Il suggerimento di Sterling che un’università italiana avrebbe potuto fare la stessa cosa mi diede la spinta definitiva. Ma chi in Italia nel mondo della ricerca avrebbe potuto darmi corda per un’idea del genere?

La risposta arrivò poco dopo quando intervistai per Nòva 24 Roberto Cingolani. L’intervista si trasformò in una chiacchierata a ruota libera che solo in minima parte trovò spazio nell’articolo, e mi fece tra l’altro scoprire in lui un appassionato di fantascienza (ricordo che citò Iain M. Banks, il tipo di scrittore che solo gli intenditori conoscono). Ci misi quasi due anni a trovare il coraggio di farmi avanti, ma alla fine gli chiesi via mail se il suo Istituto Italiano di Tecnologia sarebbe stato interessato a collaborare a un progetto del genere. Mi rispose così:

Come attività sarebbe fuori dai compiti istituzionali. Credo che l’unica cosa possibile per noi sia fornire un supporto individuale volontario. Ci sono ricercatori che potrebbero fornire opinioni sulla realizzabilità di idee e scenari fantascientifici, oppure fornire qualche spunto per nuovi racconti.

“L’unica cosa possibile” era anche l’unica che davvero mi serviva. Era in pratica un “sì”, sia pure condizionato. Ora bisognava fare il passo successivo: trovare un editore che fosse disposto a darmi un budget: non aveva senso, mi pareva, coinvolgere una prestigiosa istituzione scientifica, e far lavorare diverse persone, senza sapere chi avrebbe pubblicato il tutto, senza poter promettere dei compensi, e così via.

Purtroppo questa parte del piano si rivelò irrealizzabile. A parole tutti trovavano che l’idea fosse interessante, ma in pratica nessuno era interessato a pubblicarla. Dopo i primi rifiuti, chiesi addirittura consiglio a Giulio Mozzi, il quale fu estremamente gentile e si offrì spontaneamente di proporre il mio progetto ad alcuni editori di primo piano. Ma nemmeno col suo appoggio riuscii a destare l’interesse di qualcuno.

Stavo quasi per arrendermi, quando decisi di chiedere anche il parere del migliore amico che avessi nel mondo editoriale: Giuseppe Lippi, il curatore di Urania, con cui collaboravo da un ventennio. Lui ebbe una reazione entusiasta, e mi disse subito: “Ma te la pubblico io! Anzi, visto che per Urania sarebbe un po’ sprecato come progetto, farò il possibile per farla poi pubblicare negli Oscar.”

Non avrei mai sperato tanto: io stesso non avevo mai pensato che la mia destinazione potesse essere Urania: mi pareva che il carattere un po’ intellettuale della mia idea fosse poco adatto alla testata, che tra l’altro pubblicava molto raramente antologie, e ancor più raramente se di autori italiani. Ma se Giuseppe in persona la voleva, non sarei stato io a contraddirlo!

E così partii: tre anni fa ricontattai Cingolani, che mi mise in contatto con i responsabili della comunicazione IIT, che mi fornirono una lista di otto scienziati disposti a collaborare. Francesco Nori per la robotica, Marco De Vivo per la chimica farmacologica, Barbara Mazzolai per la robotica bioispirata, Paolo Decuzzi per la medicina di precisione, Guglielmo Lanzani per l’elettronica indossabile, Alberto Diaspro per la microscopia, Athanassia Athanassiou per la scienza dei materiali, Davide De Pietri Tonelli per la neurobiologia. Una specie di dream team! Non credevo ai miei occhi, la mia idea stava cominciando a prendere forma.

A quel punto cominciarono a profilarsi di fronte a me problemi cui non avevo affatto pensato fino ad allora. In particolare: come avrei scelto gli scrittori, e come avrei distribuito tra loro gli spunti forniti dai vari scienziati? Normalmente, quando si fa un’antologia, si contatta un numero di scrittori maggiore di quello necessario, in modo che, anche tenendo conto di defezioni, ritardi o racconti malriusciti, il numero di testi disponibili sia comunque sufficiente. Nel mio caso, ogni scrittore avrebbe lavorato su uno spunto diverso, in stretto contatto con uno scienziato disponibile a collaborare durante la lavorazione. Non era pensabile, dopo che il ricercatore si era gentilmente prestato al progetto, non utilizzare il suo spunto, ma non era pensabile nemmeno ripetere la procedura più di una volta se il racconto non fosse risultato buono. Era necessario scegliere nomi che dessero ottime garanzie di riuscita.

Mi feci una lista di scrittori che mi sembravano in grado di scrivere dei racconti letterariamente validi e allo stesso tempo di non trascurare il lato scientifico della questione, e cominciai a contattarli, e qui ebbi un’altra sorpresa: diversi autori mi dissero di no, prima o dopo aver visto gli spunti, alcuni perché troppo impegnati, ma altri perché in dubbio di non saper produrre qualcosa di buono a partire da uno spunto così specifico. Tra l’altro si tirarono indietro due donne delle quali apprezzavo moltissimo l’approccio ai temi scientifici, il che non solo era un colpo per la riuscita dell’antologia in generale, ma anche per l’equilibrio di genere dell’insieme.

Mi ero posto anche il problema di come distribuire gli spunti. Se avessi scelto io, avrei rischiato di commettere degli errori, ma se avessi lasciato la scelta agli scrittori avrei rischiato litigi e disaccordi. Provai con questo sistema: chiesi al primo gruppo di sei scrittori coinvolti di scegliere almeno tre spunti, e io avrei attribuito loro uno dei tre scelti. In questo modo avrei mantenuto il controllo, ma nessuno avrebbe potuto dire di aver ricevuto uno spunto sgradito. Funzionò abbastanza bene, ma mi accorsi di una cosa: uno degli spunti non era stato preso in considerazione da nessuno, nemmeno come terza scelta. A quel punto dovetti ritornare su una mia decisione iniziale: quella di non partecipare all’antologia come autore. L’antologista che decide di includere un proprio racconto è sempre sospetto di scarsa imparzialità. E mi è capitato più di una volta di incontrare antologie in cui il racconto meno valido era proprio quello del curatore. È vero però che ci sono notevoli eccezioni (esempio: Mirrorshades curata da Bruce Sterling; sfido chiunque a dire che Mozart in Mirrorshades è un brutto racconto!). Decisi quindi che lo spunto scartato da tutti lo avrei tenuto per me, anche perché mi sembrava invece molto ricco di elementi interessanti.

A questo punto, con diversi autori già impegnati a scrivere, ero ragionevolmente sicuro di riuscire a portare a termine il lavoro. Tornai quindi a farmi sentire da Lippi per farmi dare un termine di consegna e magari firmare un contratto. Ma rimasi delusissimo: Lippi mi disse che, con la situazione che c’era a Urania in quel momento, temeva che se avesse proposto l’acquisto glielo avrebbero bocciato. Meglio che terminassi l’antologia e gli portassi il prodotto finito: solo allora avrebbe avuto qualche speranza di farlo accettare.

Non sapevo che le cose sarebbero ulteriormente peggiorate: di lì a poco Lippi dovette lasciare la curatela di Urania dopo oltre un quarto di secolo (pochi mesi dopo sarebbe morto, lasciando un vuoto incolmabile nella fantascienza italiana). Provai a proporre il libro alla nuova gestione della collana, ma mi fu risposto che non era il momento di pubblicare un’antologia di autori italiani, e che al massimo avrebbero potuto pubblicare in appendice alcuni dei racconti e delle interviste, quando ci fosse stato spazio.

Decisi di non accettare, ma fui molto scoraggiato: chiusa la possibilità di Urania, chi avrebbe potuto pubblicare il libro? Abbandonai il lavoro sull’antologia, trascurando di trovare autori per gli ultimi spunti, di scrivere il mio racconto e di curare l’editing, dedicandomi per un anno intero alla ricerca di qualcuno disposto a far uscire il libro in libreria. Un’esperienza per molti versi istruttiva, ma sicuramente frustrante. Ho continuato a rimbalzare da un editore all’altro, ricevendo ogni volta elogi per l’idea, però accompagnati da un gentile rifiuto: nel piano editoriale della casa editrice il mio libro non si inseriva bene. E ogni editore, per farsi perdonare, me ne presentava un altro: “vai da loro, loro sì che sono quelli giusti per te”. Ogni tanto, questa catena di Sant’Antonio editoriale si interrompeva: incontravo qualcuno che si diceva interessatissimo e proponeva un incontro di persona… per poi scomparire e non rispondere più a e-mail e telefonate. Tutto tempo perso, bisognava cercare ancora.

Ci è voluto un anno per convincermi che non c’era modo di fare uscire il testo in libreria. A quel punto, era urgente trovare una soluzione alternativa: le interviste stavano invecchiando, bisognava pubblicare tutto in un tempo ragionevole. Una volta accettato di far uscire il libro distribuendolo solo online, la scelta era ovvia: Delos Digital era l’editore che poteva garantirmi una buona visibilità e un eccellente supporto tecnico. Fortunatamente Silvio Sosio accettò dubito di pubblicare il progetto, e mi propose di far uscire il libro in occasione di StraniMondi 2019. Mi restavano quindi alcuni mesi di tempo per chiudere l’antologia.

Più facile a dirsi che a farsi. Bisognava tappare un paio di buchi nell’organico con scrittori in grado di scrivere in fretta. Bisognava mettere a posto dettagli come l’introduzione, la quarta di copertina e soprattutto la copertina (per fortuna affidata a un grande nome come Franco Brambilla, grazie Delos!). Bisognava provare a ottenere una prefazione da Roberto Cingolani, che, colmo della sfortuna proprio due mesi prima dall’uscita del libro aveva lasciato la guida dell’IIT, dopo quindici anni, ed era superimpegnato col nuovo lavoro a Leonardo (alla fine riuscii a ottenerla, ma così all’ultimo momento che le prime copie cartacee stampate ne sono prive: diventeranno cimeli da collezionista?).

Ma soprattutto dovevo scrivere il mio racconto, che avevo iniziato cinque volte e cinque volte abbandonato, convinto che l’approccio non fosse quello giusto. Alla fine, spinto dalla disperazione, decisi di adottare un metodo per me del tutto inedito: presi gli incipit di tutti e cinque i tentativi falliti, e cercai di immaginare una trama che li comprendesse tutti. Strano a dirsi, funzionò. Perlomeno, è venuto fuori un racconto che mi pare più interessante rispetto alla mia media, con una trama poco lineare, un mucchio di personaggi e di cambi di tono. Aspetto di sentire il giudizio dei lettori. Sicuramente mi ha fatto un sacco di piacere l’apprezzamento di Guglielmo Lanzani, lo scienziato cui mi sono ispirato, al quale sembra essere piaciuto molto. Meno male!

Ultimo punto spinoso è stato quello del titolo. Come fare a trovarne uno che colpisse l’immaginazione del possibile acquirente, e allo stesso tempo desse un’idea generale del contenuto dell’antologia? Non era facile, dato che ogni racconto è ispirato a un campo completamente diverso della scienza. Dopo essermi arrovellato a lungo, escogitai un titolo che mi sembrava funzionare: Superrisoluzione. Si tratta di un termine preso dall’intervista con Alberto Diaspro sulla microscopia. Mi sembrava potesse suggerire la possibilità di guardare verso i nostri possibili futuri con l’accuratezza data da un microscopio (e ancora non sapevo che Franco Brambilla avrebbe messo degli enormi microscopi in copertina!).

Sono ancora convinto che l’idea potesse funzionare, ma tutti gli autori me la bocciarono senza mezzi termini: un parolone complicato che i lettori non avrebbero capito. Mi venne in soccorso Silvio Sosio, che propose Fanta-Scienza, col trattino. Un titolo che può sembrare banale, ma che in effetti sottolinea il senso dell’operazione: tornare in un certo senso alle origini della fantascienza, parlando di scienza vera. Lo abbiamo scelto e sembra avere funzionato: non dico che abbia suscitato grandi entusiasmi, ma è stato accettato da tutti senza problemi, e anche il senso del trattino sembra essere stato ben compreso.

Durante la complicata, pluriennale trafila che vi ho appena descritto, innumerevoli volte ho provato la tentazione di lasciar perdere e mollare tutto. Se non l’ho fatto è solo perché avevo chiesto ad almeno una ventina di persone di impegnarsi e dedicarci parte del loro tempo, e non sarebbe stato giusto sprecarlo così. Ora che sono arrivato in fondo, invece, sono contentissimo di non aver gettato la spugna. Tanto per cominciare, sono soddisfatto del risultato: il libro terminato non è molto lontano da quello che mi ero immaginato all’inizio del percorso.

Ma soprattutto, sembra destare un interesse e riscuotere un credito molto superiore a quello che mi aspettavo. Nelle sue prime settimane di vita ha raccolto gli elogi di Luca De Biase e Bruce Sterling, due persone per cui nutro un grandissimo rispetto. E sta raccogliendo un discreto interesse da parte della stampa. È troppo presto per valutare quanto riuscirà a vendere, ma mi sembra che si stia facendo notare, ben più di quanto era lecito immaginare. Speriamo che continui così.

Addirittura mi è già stato chiesto più volte se ci sarà un seguito, un Fanta-Scienza 2, o magari 3. Se me lo aveste chiesto un anno fa, avrei risposto: mai più! Ora invece sto cominciando a pensarci. Per me potrebbe davvero diventare un appuntamento annuale, magari con una formula un po’ diversa. Dipenderà molto dal successo del libro, e dalla collaborazione che mi permetterà di ottenere nel mondo scientifico e in quello editoriale.

In ogni caso non posso che ringraziare tutti coloro che, in tanti momenti, mi hanno incoraggiato e dato una mano. Ne è valsa davvero la pena!

Ora, se non l’avete ancora fatto, leggete il libro, o perlomeno compratelo!